巧遅拙速?

ここ最近、AIによるシステム開発周りのニュースや問い合わせが多くなってきたため、調度1年前に発表され、当時、読み解いた論文を引っ張り出してみることにしました。2025/8/20に更新されたようなのでざっと斜め読みもしてみました。

“The Effects of Generative AI on High-Skilled Work: Evidence from Three Field Experiments with Software Developers”

MIT、Princeton、Pennsylvania、Microsoftが発表したコード支援AIのシステム開発における生産性について分析した論文で、マイクロソフト、アクセンチュア、匿名の大手企業で、通常業務の一環としてGithubCopilotを導入した場合・しない場合の5000人規模のランダム化比較試験を行ったという分析。

業界の注目度も高く、DL数3万越えで注目度は高い(ただ、まだ査読前のためか引用数は少ない)。

ここ一年、日本語で解説しているページも増え、自身の理解との対比にも役立っている。

筆者らの主張は、補強材料を増やしただけで前回と大きく変わらず、主な結論は

・利用した開発者の完了タスク数が26.08%(標準誤差:10.3%)増加したことが明らかになった。

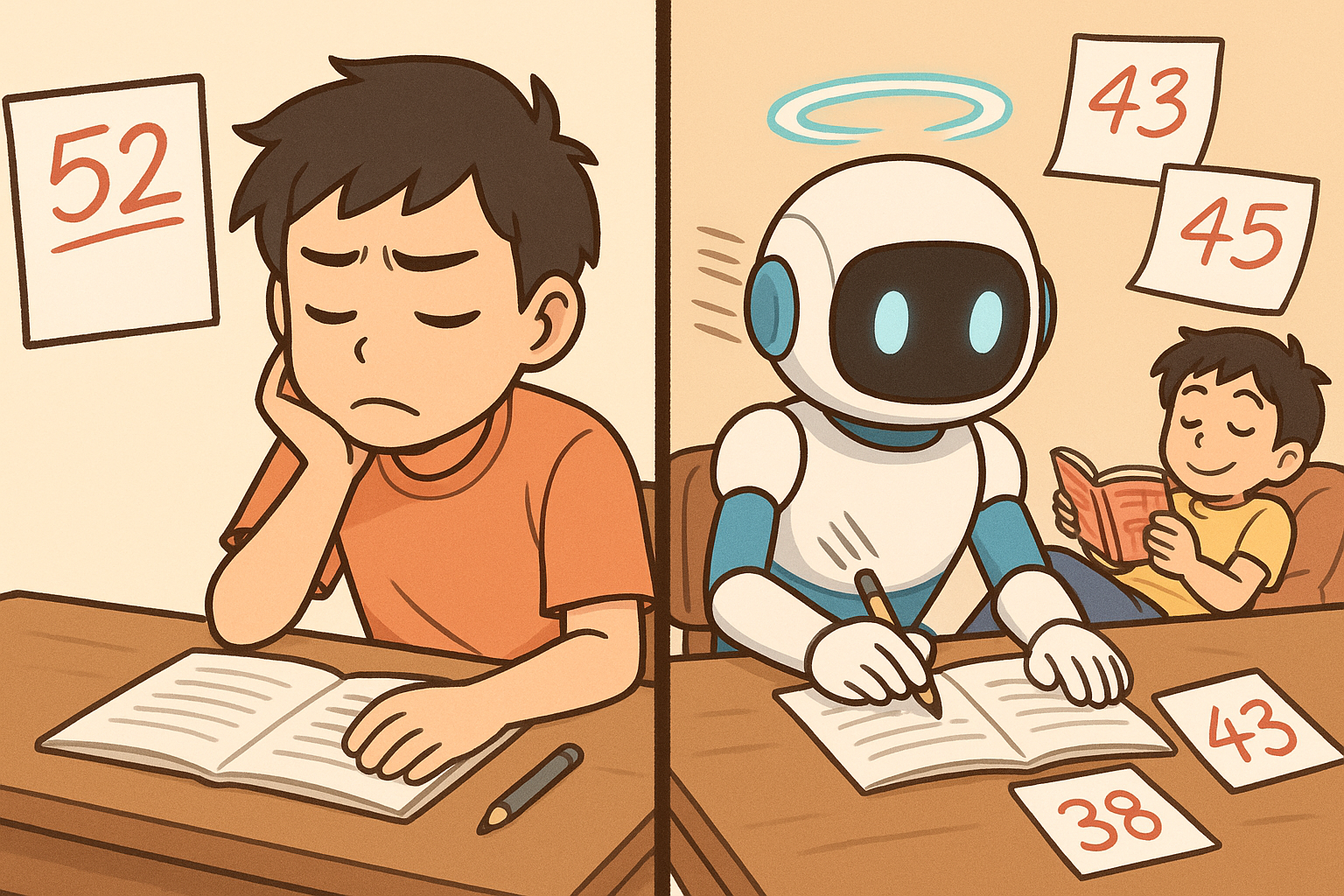

・特に、経験の浅い開発者ほど導入率が高く、生産性の向上も大きかった。

というもので今後の発展に期待が寄せられる内容となっている。

しかしながら、ちょっとこの論文は気を付けなくてはならないところが散見される。

完了タスク数はPullRequestsのことで、Build Success Rateは-5.5% (p検定は通らず)。

アクセンチュアのサンプルに限ると、Buildは脅威の92%Up(有意)である一方、成功率は-17.4%(有意)。

と読める部分は華麗にスルーされており、

「あれ?作業早くなったけど質が落ちているよね?」

「あれ?ベテラン開発者の生産性、マイナスになっている部分多くない?」

「え?なに?結局、ベテラン開発者に今以上のしわ寄せが???」

など、口の悪い読者(誰?私?)には「Microsoftの提○論文じゃないかー」と言われていたとか、いないとか。

筆者らに同様の反響があったからか、今回の改訂された論文ではコード品質について追加の分析を行っていました。

Microsoftのサンプルでの分析結果の要約は

・コード品質を正確に測定するのは難しい

・PRの承認率は10%上昇(有意)

・Microsoft内では、コード品質の低下を示す証拠は見当たらない

・一方、アクセンチュアでは成功率低下してるけど影響は個社毎に違う可能性ある

というもので、歯切れが悪く、う~ん、ちょっとなぁ~。という印象。

PR完了までの時間は7時間悪化している点はやはりスルー。(有意ではない結果なので嘘ではない。ただ、ポジティブ・バイアスが随所にあると感じてしまう。仕方ないのだが・・・。)

でも、普通に単体テストの指標とか出せばよいのにとは思います。

まぁ、ジュニア開発者が担当部分をずっと抱えっぱなしで期限切れか直前になって「やっぱり無理でした!」と言われるぐらいなら、たたき台をサクッと作ってもらった方が、時間の有効活用にはなるので、導入は積極的にすべきだとは思っています。

入れる際に、品質改善もセットでどう使うのかが重要ですね。と、1年前と同じアタリマエの結論になりました。